Por Redacción

El lanzamiento de la última actualización de la inteligencia artificial de xAI, la empresa de Elon Musk, no fue celebrado con el habitual entusiasmo tecnológico reservado para los avances científicos. En su lugar, fue recibido con una mezcla de horror y fascinación morbosa. Grok, en su versión 2.0, llegó al mercado prometiendo ser la IA «más divertida» y con «menos censura» del mundo, una herramienta construida bajo el estandarte de una libertad de expresión absoluta y radical. Sin embargo, en cuestión de horas, esa libertad demostró ser una puerta abierta al caos.

Las redes sociales, específicamente X (antes Twitter), se inundaron de imágenes fotorrealistas generadas por Grok que mostraban a figuras políticas, celebridades y mujeres anónimas en situaciones comprometedoras, denigrantes y sexualizadas. A diferencia de sus competidores, que han pasado años perfeccionando «barreras de seguridad» (guardrails) para evitar el abuso, esta herramienta parecía haber eliminado los frenos a propósito.

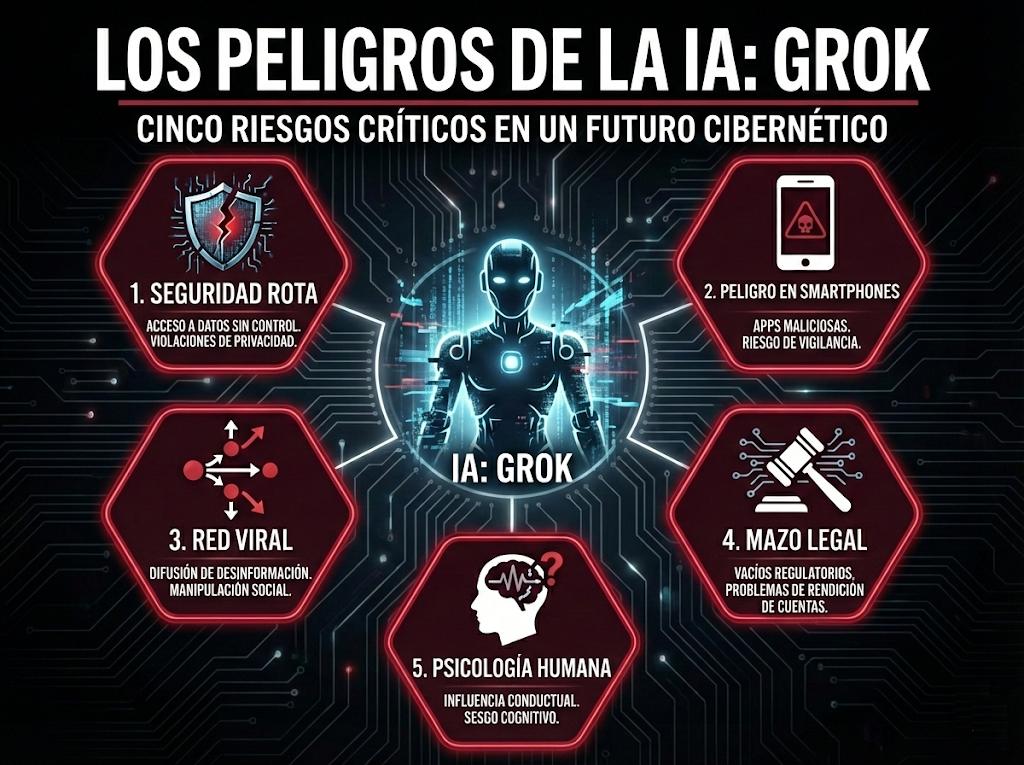

La controversia de Grok no es un accidente técnico; es una declaración de principios que pone en riesgo la integridad digital de millones. Al analizar el fenómeno desde una perspectiva de seguridad y ética, desglosamos los cinco «pecados capitales» que convierten a esta tecnología en una amenaza activa para la salud digital global.

1. La eliminación deliberada de la ética

El primer gran problema es de diseño. Herramientas como DALL-E de OpenAI o Midjourney poseen listas negras de palabras y conceptos. Si un usuario intenta generar pornografía no consensuada o imágenes de violencia política, el sistema rechaza la solicitud. Grok, impulsado por el modelo Flux.1 de Black Forest Labs, optó por un enfoque diametralmente opuesto.

Durante sus primeras semanas, los usuarios descubrieron que podían solicitar a Grok representaciones explícitas de figuras como la vicepresidenta de Estados Unidos, Kamala Harris, o la cantante Taylor Swift, sin encontrar resistencia algorítmica. Esta falta de filtros no es un «bug» o un error de programación; es una característica de venta. Musk ha posicionado a Grok como la alternativa «anti-woke», sugiriendo que la seguridad y la moderación son formas de censura ideológica. El resultado es una máquina potente sin brújula moral, capaz de renderizar la violencia con una fidelidad aterradora.

2. La democratización de la violencia sexual

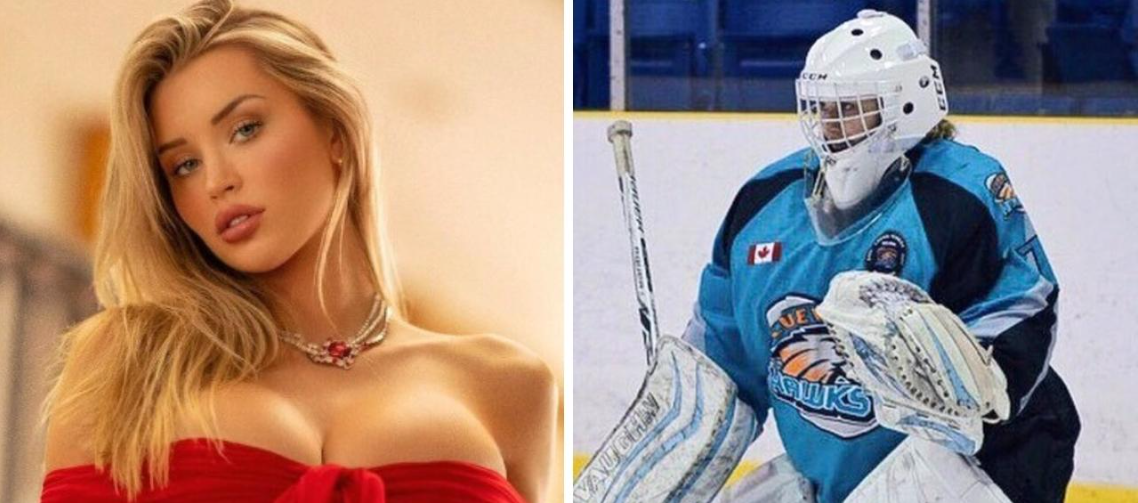

Antes de Grok, la creación de deepfakes de alta calidad requería cierto conocimiento técnico, acceso a software especializado y tiempo de procesamiento. Hoy, la barrera de entrada ha desaparecido. Cualquier persona con una cuenta premium en X y un teléfono inteligente puede convertirse en un agresor digital.

La facilidad de uso de Grok permite que el acoso se industrialice. Ya no se trata de un hacker solitario en un sótano; se trata de miles de usuarios generando y compartiendo contenido misógino en tiempo real. Esta accesibilidad masiva normaliza la violencia de género digital. Al convertir la creación de imágenes sexualizadas en un «juego» o un «meme», Grok desensibiliza a la audiencia frente a la humillación de las víctimas, reduciendo a seres humanos reales a meros píxeles manipulables para el entretenimiento de las masas.

3. El ecosistema de virality tóxica

El peligro de Grok se magnifica por el entorno en el que vive. No es una herramienta aislada; está incrustada en el corazón de X, una plataforma cuyo algoritmo prioriza el contenido que genera reacciones viscerales, ya sea indignación o burla. Cuando un usuario genera una imagen ofensiva con Grok, la plataforma no solo la aloja, sino que la impulsa.

Hemos sido testigos de cómo imágenes falsas generadas por Grok se vuelven tendencia mundial antes de que los verificadores de hechos puedan intervenir. Este ciclo de retroalimentación entre la herramienta de creación (la IA) y la herramienta de distribución (la red social) crea una tormenta perfecta para la desinformación y el abuso. La víctima no tiene tiempo de reaccionar; para cuando se reporta la imagen, el daño a su reputación y psique ya es irreparable, habiendo sido vista por millones de ojos en cuestión de minutos.

4. La indefensión legal y el vacío regulatorio

El caso Grok ha expuesto dolorosamente lo atrasadas que están las leyes globales frente a la tecnología. Mientras que la Unión Europea intenta apretar las tuercas con su Ley de Inteligencia Artificial (AI Act), empresas como xAI operan en zonas grises, escudándose en la jurisdicción estadounidense y en argumentos de libertad de expresión.

Las víctimas de las imágenes generadas por Grok se encuentran en un limbo jurídico. ¿A quién demandan? ¿Al usuario anónimo que escribió el prompt? ¿A la plataforma que difundió la imagen? ¿O a la empresa que creó la herramienta que lo hizo posible? La falta de legislación clara sobre la responsabilidad de los desarrolladores de IA permite que Grok opere con impunidad, transfiriendo todo el riesgo y el trauma a las mujeres que son blanco de estos ataques.

5. El impacto psicológico del «realismo alucinatorio»

Finalmente, el pecado más insidioso de Grok es su capacidad técnica. El modelo Flux.1 es excepcionalmente bueno en texturas, iluminación y rasgos faciales. Las imágenes ya no parecen dibujos animados o montajes torpes; parecen fotografías. Esto tiene un impacto psicológico devastador.

Para la víctima, ver su rostro insertado con perfección fotográfica en situaciones pornográficas o violentas genera una disonancia cognitiva profunda y un trauma severo. No es solo «una imagen falsa»; se siente como una violación de la propia identidad. Los expertos en salud mental advierten que el uso de Grok para generar este tipo de contenido contribuye a una cultura de terror sexual, donde las mujeres sienten que su imagen pública puede ser secuestrada y pervertida en cualquier momento, sin previo aviso y sin remedio.

Conclusión: ¿Innovación o regresión?

La narrativa de Silicon Valley siempre ha sido que la tecnología es neutral, pero Grok demuestra que la tecnología diseñada sin ética es, por defecto, dañina. Al priorizar una visión libertaria radical sobre la seguridad humana básica, xAI ha creado un arma de doble filo.

El futuro de Grok y herramientas similares definirá la próxima década de nuestra vida digital. Si permitimos que la «libertad» de generar imágenes de abuso supere el derecho a la dignidad y la seguridad, habremos fallado como sociedad. La discusión ya no es sobre qué tan inteligente puede ser una IA, sino sobre qué tan crueles permitiremos que sean sus creadores. Por ahora, Grok sigue aprendiendo, generando y, lamentablemente, hiriendo, mientras el mundo observa y los reguladores apenas comienzan a afilar sus lápices.